运维工具介绍

最近更新时间: 2025-10-11 18:10:00

Barad管控平台

- 流水线触发

- 单点触发:用于执行单个节点。选择起点和终点为该节点,执行步骤会将选择的步骤展示。

- 部分触发:用于执行部分连续节点,选择起点和终点为链路的节点,执行步骤会将选择的步骤展示。

- 整体触发:用于执行整个流水线,选择节点的起点和终点。

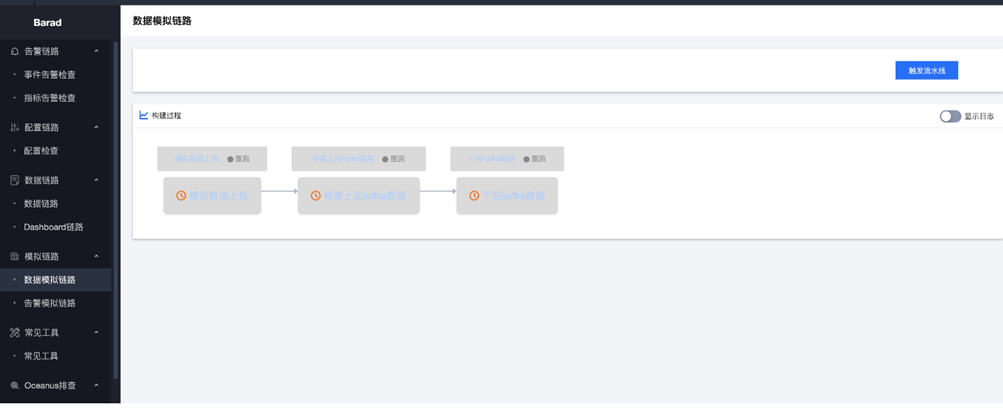

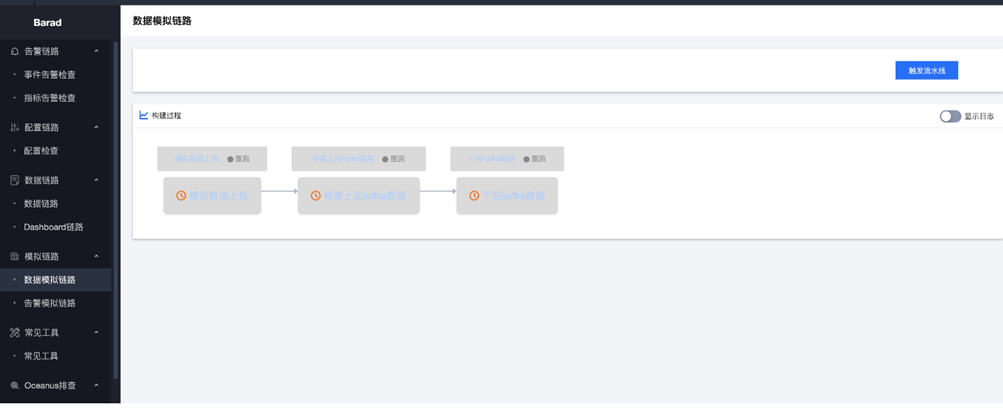

- 数据链路

- 数据抓包

- 使用说明

| 参数 | 示例 |

|---|---|

| 命名空间 | qce/cvm |

| 指标 | cpu_usage |

| 抓包时间 | 120s |

| 过滤参数 | 98615d0b-5c29-46ec-8426-257da08b5494 |

- 推荐参数 抓包时间尽量不要太长,推荐时间为120s,抓包时间为2分钟。

- Kafka 抓包

检查上层kafka的数据

- 使用说明 用于nws到kafka链路的检查。

| 参数 | 示例 |

|---|---|

| 命名空间 | qce/cvm |

| 指标 | cpu_usage |

| 消费时间 | 600 |

| 消费数量 | 20 |

| 过滤参数 | 98615d0b-5c29-46ec-8426-257da08b5494 |

- 推荐参数 消费时间:600 消费数量:20

- 检查下层kafka数据

- 使用说明 用于flink到kafka的数据

| 参数 | 示例 |

|---|---|

| 命名空间 | qce/cvm |

| 指标 | cpu_usage |

| 消费时间 | 600 |

| 消费数量 | 20 |

| 过滤参数 | 98615d0b-5c29-46ec-8426-257da08b5494 |

- 推荐参数 用于nws到kafka链路的检查。

- Api查询

- 使用说明 请求id:前端的seqid

- 模拟链路

模拟数据链路

- 使用说明 通过模拟qce/tsf的模拟数据,模拟一遍数据链路的排查。

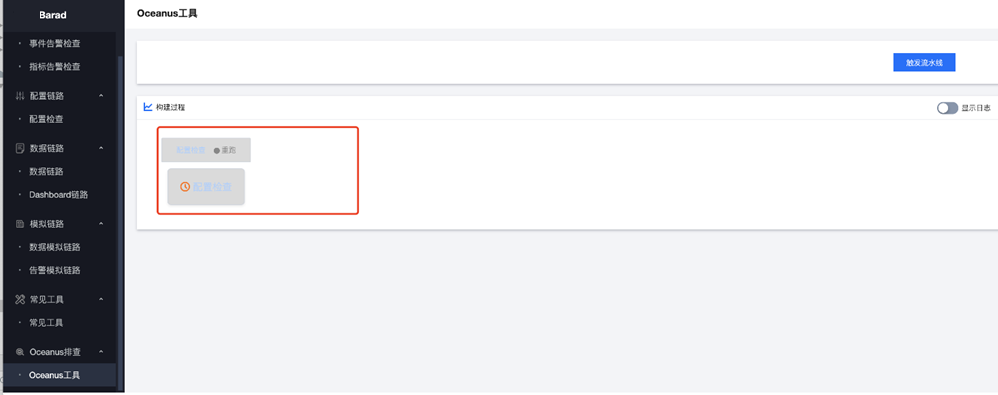

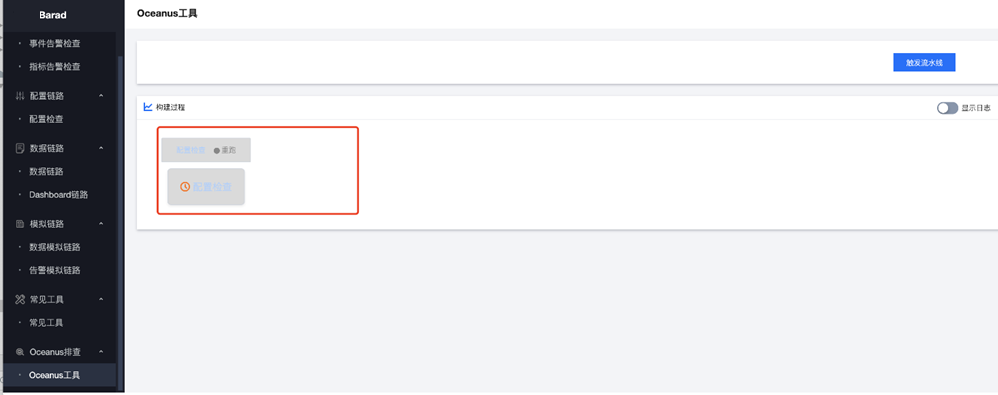

- Oceanus排查

- 使用说明

检查oceanus的常用配置检查。

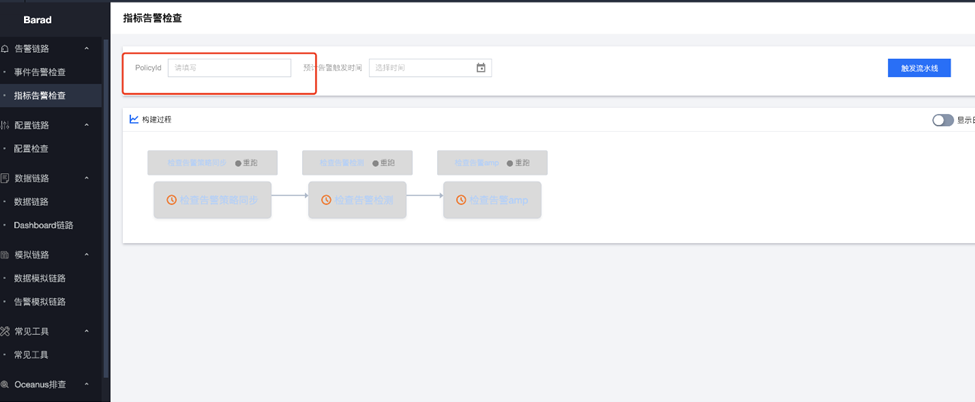

- 告警链路

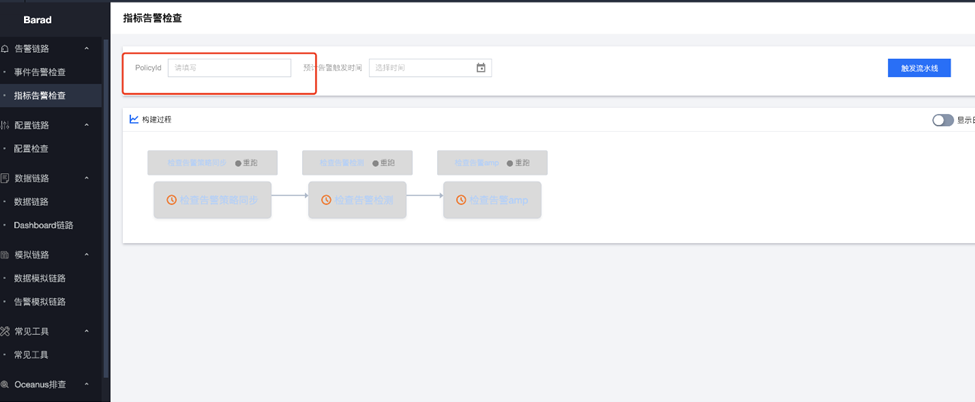

- 指标告警

- 使用说明 指标告警链路的排查是具有前后依赖关系,当前一个节点发现有问题,后续节点不会继续执行。 policyId:前端创建策略生成的policyId

- 示例: policyId :policy-6vmfyugf

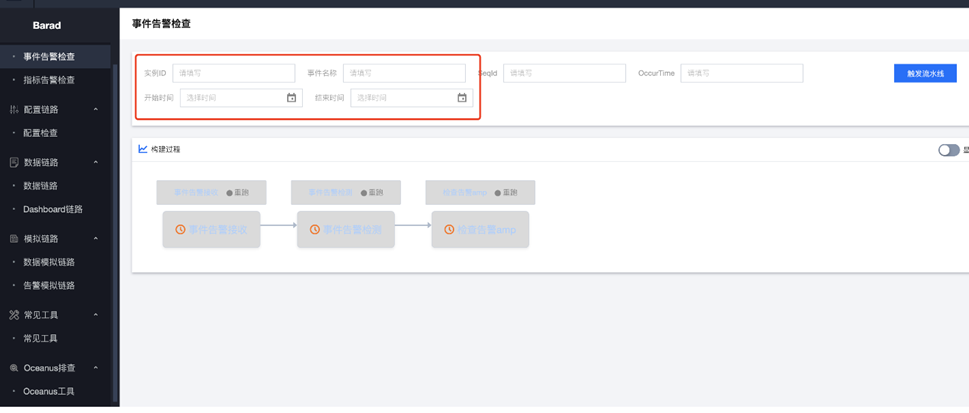

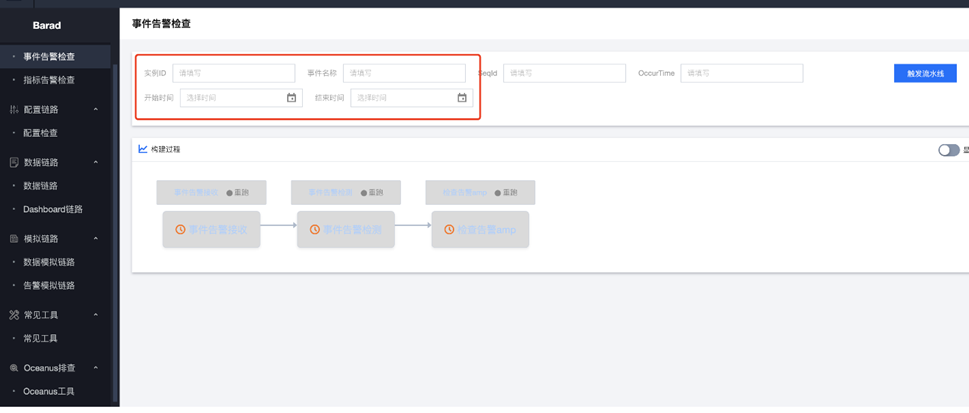

- 事件告警

- 使用场景一:对于不确定触发时间的事件告警。

- 使用场景二:于重新新触发的事件告警或者准确知道事件触发时间。 填写事件名称,过滤实例,OccurTime 执行整条链路的检查。

- 使用说明

填写事件名称,过滤实例,开始时间,结束时间,执行节点1,在节点1展示的信息中选出确定的事件发送的seqid

在参数中填写seqid,执行链路2-3,完成事件告警的检测。

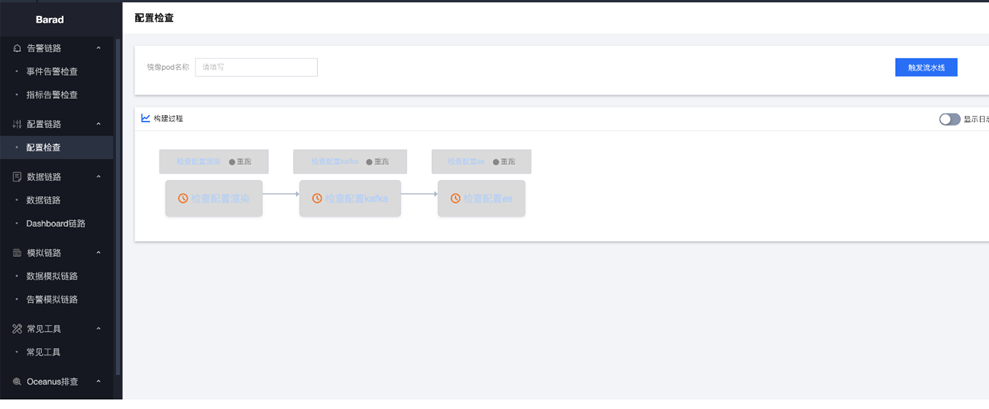

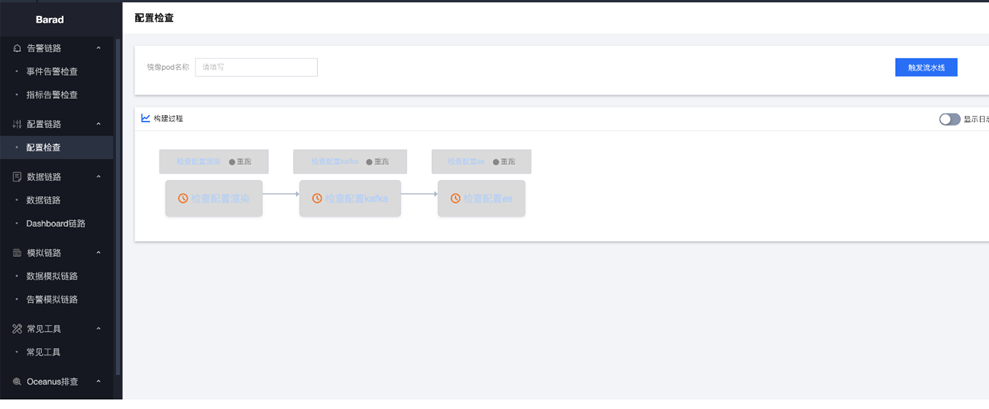

- 配置链路

- 配置检查

- 使用说明 镜像pod的名称:为需要渲染配置检查pod名称

- 示例: barad-api-go

- 推荐参数

为了避免检查master节点的上的所有pod的渲染配置,推荐使用pod的名称来进行要检查的配置渲染信息。

运维常用命令

- Flink常用操作

- 启动、停止流任务 在tcloud-barad-skywalker的/usr/local/services/barad-skywalker/job目录下

- 执行run-job.sh启动脚本

- 执行stop-job.sh启动脚本

- Flink补点操作

- 配置文件介绍

job.properties

kafkaStartTimestamp 为kafka消费的毫秒时间戳

validBegin 为设定的补算的开始的毫秒时间戳

validEnd 为设定的补算的结束的毫秒时间戳

kafkaStartTimestamp 为kafka消费的毫秒时间戳

validBegin 为设定的补算的开始的毫秒时间戳

validEnd 为设定的补算的结束的毫秒时间戳注意:

推荐validBegin和kafkaStartTimestamp设置为一样。

- 脚本介绍 create-supplement-job.sh 为创建补算的任务,并运行补算的作业。 run-supplement-job.sh 为手动运行补算的任务。 stop-supplement-job.sh 为手动停止补算的任务。 补算步骤

- 进入到tcloud-barad-skywalker容器中的/usr/local/services/barad-skywalker/job目录下。

- 修改job.properties 文件中的kafkaStartTimestamp,validBegin,validEnd,将validBegin,kafkaStartTimestamp设定的补算的开始的毫秒时间戳,validEnd设定的补算的结束的毫秒时间戳。

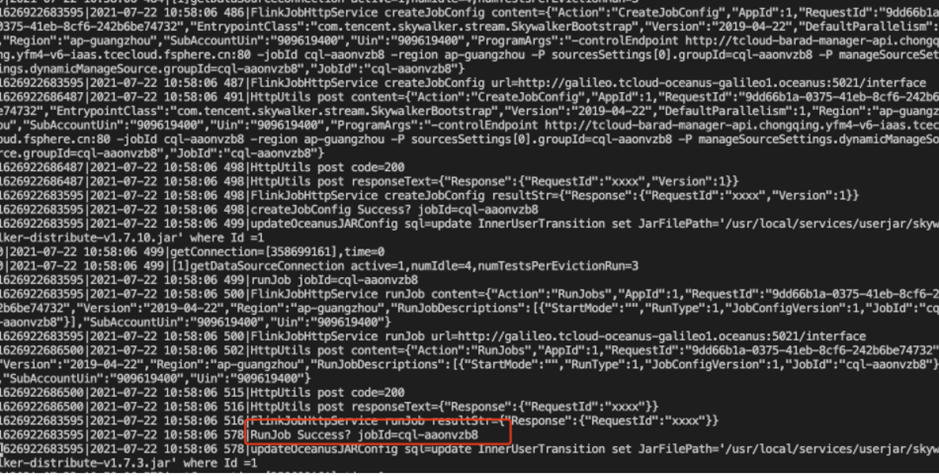

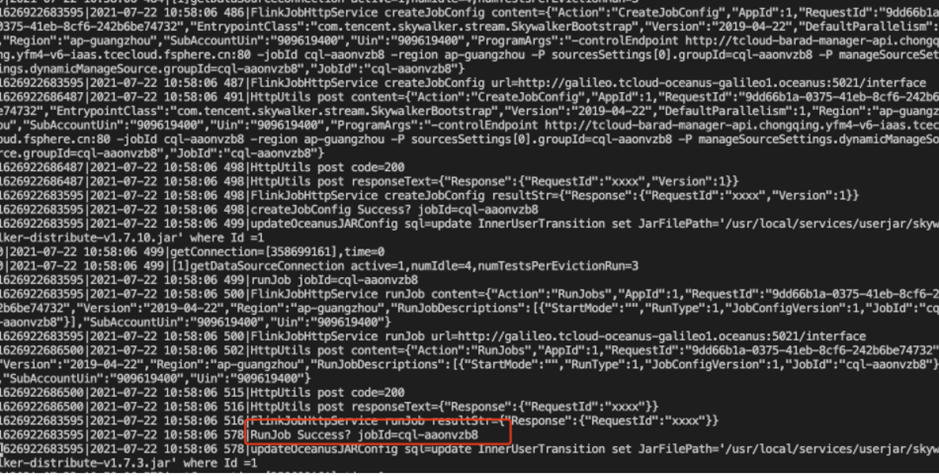

- 运行create-supplement-job.sh,查看/usr/local/services/barad-skywalker/logs下flink-supplement-job.log的最新的日志。整条的日志tranceId为运行脚本的时间,可以根据时间来获取整条任务执行过程。

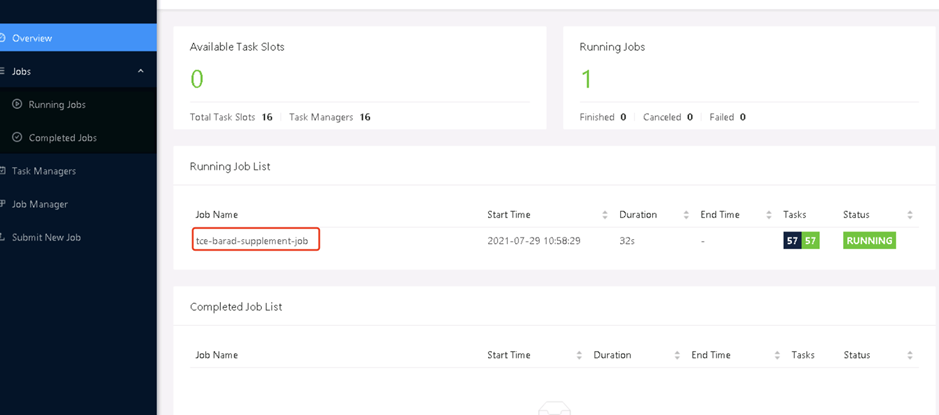

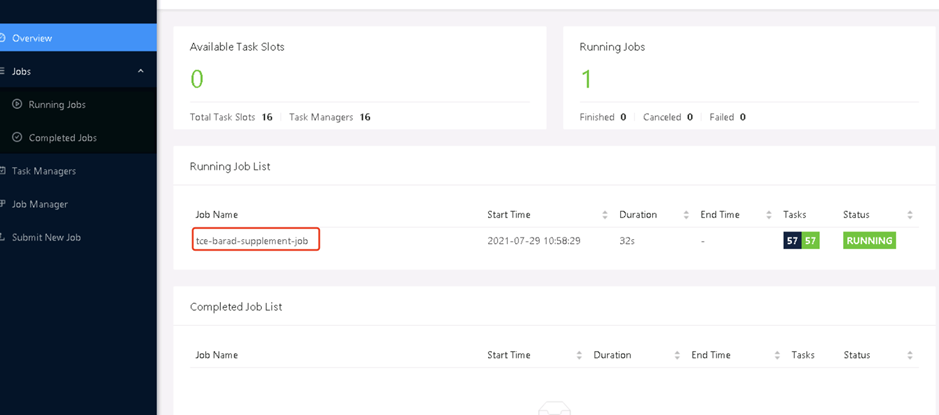

如果看到上述图中的记录,则说明创建补算任务和运行任务成功。可以从flink-ui上查看补算任务运行的效果。

如果看到上述图中的记录,则说明创建补算任务和运行任务成功。可以从flink-ui上查看补算任务运行的效果。

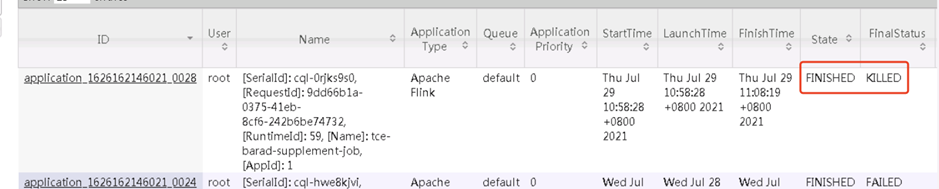

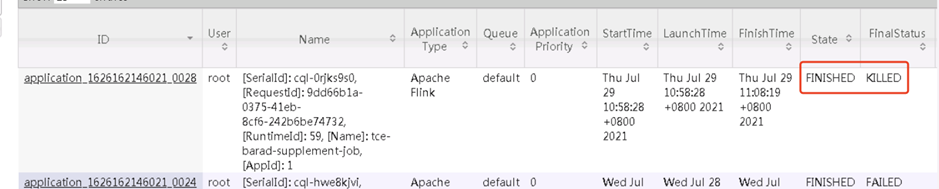

- 当补算任务执行完成后,会改变数据库manager中的ExpectStatus的状态数据,执行创建补算任务的脚本会有定时任务将每分钟读取这个数据库中的状态,将发送任务停止的消息,停到补算任务。整个补算任务流程结束。

可以从数据上查看到这段时间补算的结果,已经将这段时间无数据填充。示例图中是从10.41-10.51的补算。

可以从数据上查看到这段时间补算的结果,已经将这段时间无数据填充。示例图中是从10.41-10.51的补算。注意:

如果发现补算任务一直没有停止,可以手动执行stop-supplement-job.sh ,进行停掉补算任务。

- Kafka操作命令

Kafka节点启动

cd /usr/local/services/kafka_2.11-1.1.1/bin/

./kafka-server-start.sh-daemon

../config/server.properties

查看启动日志

tailfkafkaServer.out

jps 查看kafka进程是否正常

查看 topic 列表

./kafka-topics.sh--zookeeper {zookeeperIP}:{zookeeperPort}/kafka –list

查看指定topic详情

./kafka-topics.sh--describe --zookeeper {zookeeperIP}:{zookeeperPort}/kafka --topic {topicname}

删除topic

./kafka-topics.sh–delete --topic {topicname} --zookeeper {zookeeperIP}:{zookeeperPort}/kafka

创建topic

./kafka-topics.sh--create --zookeeper {zookeeperIP}:{zookeeperPort}/kafka --replication-factor{x} -partitions {y} --topic {topicname}- Es相关命令

登陆到ES主机上执行。

集群健康状态: curl -XGET http://localhost:9200/_cluster/health\?pretty

集群node信息: curl -XGET http://localhost:9200/_nodes/process?pretty

查看集群状态: curl http://localhost:5100/_search/clusters

查看所有metric: curl http://localhost:9200/_metrics

查看分片已使用空间: curl http://localhost:9200/_cat/allocation?v

查看分片状态: curl -XGET http://localhost:9200/_cat/shards

查看索引状态: curl -XGETlocalhost:9200/_cat/indices?v&pretty

kafkaStartTimestamp 为kafka消费的毫秒时间戳

validBegin 为设定的补算的开始的毫秒时间戳

validEnd 为设定的补算的结束的毫秒时间戳

kafkaStartTimestamp 为kafka消费的毫秒时间戳

validBegin 为设定的补算的开始的毫秒时间戳

validEnd 为设定的补算的结束的毫秒时间戳 如果看到上述图中的记录,则说明创建补算任务和运行任务成功。可以从flink-ui上查看补算任务运行的效果。

如果看到上述图中的记录,则说明创建补算任务和运行任务成功。可以从flink-ui上查看补算任务运行的效果。

可以从数据上查看到这段时间补算的结果,已经将这段时间无数据填充。示例图中是从10.41-10.51的补算。

可以从数据上查看到这段时间补算的结果,已经将这段时间无数据填充。示例图中是从10.41-10.51的补算。